En 1933 el físico búlgaro Fritz Zwicky fue el primero en sugerir la existencia de un componente invisible pero fundamental para entender la estructura del Universo y en particular las observaciones que provenían de la cinemática, es decir el movimiento de las galaxias.

El experto mostró que las mediciones de la velocidad orbital de las galaxias que giran en torno al centro de inmensos cúmulos galácticos era diez veces mayor que la provocada por la acción de la gravedad de toda la materia conocida al interior de su órbita, y propuso la respuesta al interrogante que esto planteaba: la materia oscura.

El nombre que se le dio tiene que ver con su principal característica que es la de no generar ningún tipo de radiación electromagnética, o dicho de otro modo, no emitir luz, lo que hace imposible su registro de manera directa y que sólo pueda inferirse a partir del efecto gravitacional que tiene sobre los cuerpos celestes que sí son observables.

Si bien al comienzo la comunidad científica internacional no le dio crédito a ese postulado, la información recabada a lo largo de casi un siglo dio cuenta no sólo de su existencia, sino también de su predominancia: se estima que el 85 por ciento de la materia contenida en el Universo es materia oscura.

De este modo, se configuró como uno de los principales desafíos para la astrofísica moderna para, por un lado, conseguir evidencia directa y, por otro, dilucidar cuál fue la partícula elemental que le dio origen y comprender su distribución al interior de las galaxias. En este último camino se encuentra un investigador del CONICET La Plata quien acaba de publicar un trabajo realizado en colaboración con colegas italianos en el que propone un nuevo modelo para explicar qué ocurre en la Vía Láctea.

“Existe un consenso en que la materia oscura tiene que estar formada por una partícula elemental aún desconocida que habría nacido en el Universo temprano justo después del Big Bang, para luego agruparse a causa de la gravedad en grandes aglomeraciones que son los antecedentes de las galaxias que vemos hoy”, comenta Carlos Argüelles, investigador asistente del CONICET en la Facultad de Ciencias Astronómicas y Geofísicas de la Universidad Nacional de La Plata (FCAG, UNLP) y primer autor del trabajo.

“Este problema ha sido abordado de muy buena manera a lo largo de las últimas tres décadas en base a simulaciones numéricas hechas con súper computadoras que ponen billones de partículas a interactuar bajo su propia gravedad”, explica Argüelles y agrega: “Estos modelos analizan la aglomeración consecutiva de tales elementos masivos según transcurre el tiempo para entender la formación de las distintas estructuras del Universo, y han logrado dar una definición acertada de cómo es su distribución tanto a gran escala, en cúmulos de galaxias, como en las partes externas de éstas”.

Pero según comenta el experto, este tipo de simulaciones tienen una limitante en los costos que suponen y en su resolución: el pixel mínimo es muy grande y sólo permite describir con exactitud lo que sucede en los bordes externos de las galaxias, pero no así en su centro, a una escala más pequeña. En 2015, mientras realizaba sus estudios de posdoctorado en Italia, Argüelles comenzó a trabajar en un modelo alternativo basado en unas partículas elementales denominadas fermiónicas que combina conceptos de física cuántica, relatividad general y termodinámica, que permitiría resolver este obstáculo: el esquema Ruffini-Argüelles-Rueda (RAR).

“Es un modelo que no requiere grandes computadoras porque partimos del supuesto de que el sistema galáctico que analizamos ya está formado y en equilibrio, es decir prescindimos de toda su historia previa. Lo que hicimos fue poner los fermiones a interactuar en ese esquema para analizar su comportamiento”, describe.

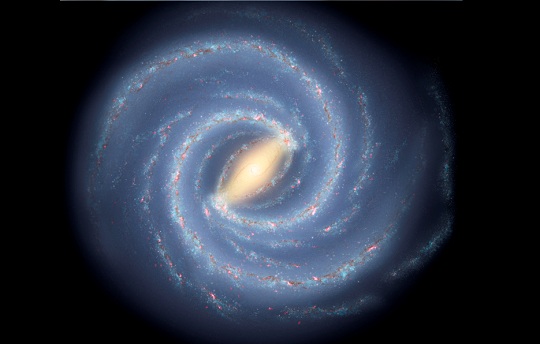

Por su restringida resolución, las simulaciones numéricas tradicionales parten del supuesto de la existencia de un agujero negro súper masivo –es decir, una región del espacio-tiempo que contiene una concentración densa de masa de la que ninguna partícula material, ni siquiera la luz, puede salir– en el centro de las galaxias. Por ejemplo, el de la Vía Láctea se denomina Sagittarius A*, por encontrarse en la región conocida como la constelación de Sagitario, y se encontraría a 26 mil años luz del Sistema Solar con una masa 4 millones de veces superior a la del Sol.

“El esquema que nosotros proponemos significa un corrimiento de ese paradigma. Por un lado, confirma lo que ya se sabía respecto de la distribución de materia oscura en las zonas externas de las galaxias, en lo que se conoce como el halo, y da a conocer cuál es la naturaleza y masa de las partículas en términos de fermiones. Pero, por otro, estos fermiones presentan una concentración muy densa hacia el centro galáctico, lo que permite prescindir de la idea de la existencia de un agujero negro en ese lugar”, subraya.

Para corroborar esto, los expertos contrastaron el modelo con la dinámica de las estrellas que se encuentran más cerca del centro de la Vía Láctea y que vienen siendo monitoreadas desde hace más de una década con grandes telescopios: “La órbita de estos objetos se condice con la generada por la gravedad de ese núcleo denso y compacto sin necesidad de un agujero negro central, tal como lo propusimos”, resalta Argüelles.

La alternativa que el modelo propone al paradigma del agujero negro central es su principal aporte. “La Vía Láctea fue el primer test porque es el caso del que se cuenta con más información. Pero lo interesante es que no sólo aplica a ésta sino que ahora estamos abocados a otras galaxias más lejanas y de distinta configuración para ver cómo se correlaciona con las mediciones”, cierra.